2D 이미지로 3D 아바타 생성부터 AR/VR을 이용한 버추얼 태권도 게임까지! 최근 사람의 동작을 학습하는 '모션 트래킹' 기술이 부쩍 증가하고 있어요.🔺 모션 트래킹은 객체의 움직임을 추적하고 기록하는 기술로, 실시간으로 움직임을 캡처해 디지털 환경에 적용한다는 특징이 있는데요. 이에 영화, 게임, 가상 현실 등의 다양한 분야에 응용 활용되고 있답니다. 이전 콘텐츠에서 많이 소개했던 'YOLO' 모델이 단 한 번에 객체를 인식한다면, 오늘 소개해 드릴 모션 트래킹 모델 'SAMURAI'는 클릭 한 번에 복잡한 객체 움직임을 추적할 수 있게 해줘요.

오픈소스로 최신 공개된 모션 트래킹 모델, SAMURAI는 얼마나 빨리 정확하게 객체를 추적할 수 있을까요?🏃➡️

SAMURAI 모델의 베이스가 된

|

객체 추적 모델 SAM 이란?

Segment Anything Model, 일명 SAM으로 불리는 Meta의 AI 모델은, 사용자가 원하는 모든 이미지의 객체를 단 한 번의 클릭으로 “분할”할 수 있는 기능을 제공해요. 점이나 박스와 같은 다양한 입력 프롬프트를 활용하여 객체를 배경이나 다른 객체에서 분리하고, 모양과 경계를 윤곽으로 나타내는 고품질의 객체 마스크를 생성할 수 있어요. 이 모델은 모호한 프롬프트가 주어지면 여러 유효한 마스크를 하나의 출력으로 평균화하여 다양한 결과를 제공해 줘요. 🎭

따라서 SAM 모델은 추가 학습 필요 없이 익숙하지 않은 사물과 이미지에 대한 제로샷 일반화를 갖춘 신속한 세분화 시스템이라고 이해할 수 있어요. 여기서 제로샷 일반화는 사물이 무엇인지에 대한 일반적 개념을 학습해서, 추가 훈련 없이도 익숙하지 않은 사물과 이미지에 대한 일반화를 시키는 것을 말합니다 :) 😃

SAM의 주요 기능

🟦 객체 분할(Instance Segmentation): SAM은 이미지를 분석하여 특정 객체를 식별하고, 객체의 경계를 정확하게 분할해요. 사용자는 원하는 객체를 클릭하거나 박스를 그려서 객체를 선택할 수 있어요.

🟦 유연한 입력 프롬프트: 사용자는 점, 사각형 또는 다각형 형태의 다양한 입력 프롬프트를 사용할 수 있어, 모델이 어떤한 객체를 분할해야 할지 명확하게 지정할 수 있어요.

🟦 고속 처리: SAM은 실시간으로 빠른 속도로 객체를 분할하며, 다양한 객체와 배경에서 높은 성능을 발휘해요.

🟦 다양한 확장 출력: 모델은 동일한 입력에 대해 여러 가지 가능한 마스크를 생성할 수 있어, 사용자가 필요에 따라 다양한 결과 생성이 가능해요. 특히 3D 들어 올리기, 콜라주와 같은 창의적 작업에 다수 사용돼요.

🟦 다양한 응용 분야: SAM은 이미지에서 특정 객체를 정확하게 분할할 수 있어, 의료, 자율주행, AR/VR 등 컴퓨터 비전 응용 프로그램에서 객체 인식과 트래킹에 효과적이에요.

SAM과 YOLO의 비교

앞서 콘텐츠에서 소개했던 YOLO 모델과 같이 SAM 모델 또한 실시간 객체 처리가 가능하다는 공통점이 있었어요. 두 모델은 모두 객체 인식과 관련된 중요한 AI 모델이지만, 목적이나 역할에 있어 확실한 차이가 있는데요. 아래의 표를 통해 간단한 비교를 확인해 볼 수 있답니다!

|

SAM(Segment Anything Model)

|

YOLO (You Only Look Once)

|

||

|

목적

|

이미지 객체 분할 중심

|

목적

|

실시간 객체 감지와 인식 중심

|

|

기능

|

클릭 한 번, 몇 가지 프롬프트로 이미지 내

특정 객체 식별 및 경계 정의 |

기능

|

전체 이미지를 한 번만 확인하여, 각 객체에 대한

바운딩 박스와 객체 클래스 동시 예측 |

|

출력

|

객체의 마스크(픽셀 수준) 생성, 이는 특정 객체의 경계를 명확하게 시각화하는 데 유용

|

출력

|

객체 바운딩 박스와 클래스 레이블 변환으로,

특정 객체가 이미지의 어느 부분에 존재하는지 정보 제공 |

SAM, 복잡한 객체 추적에서의 한계

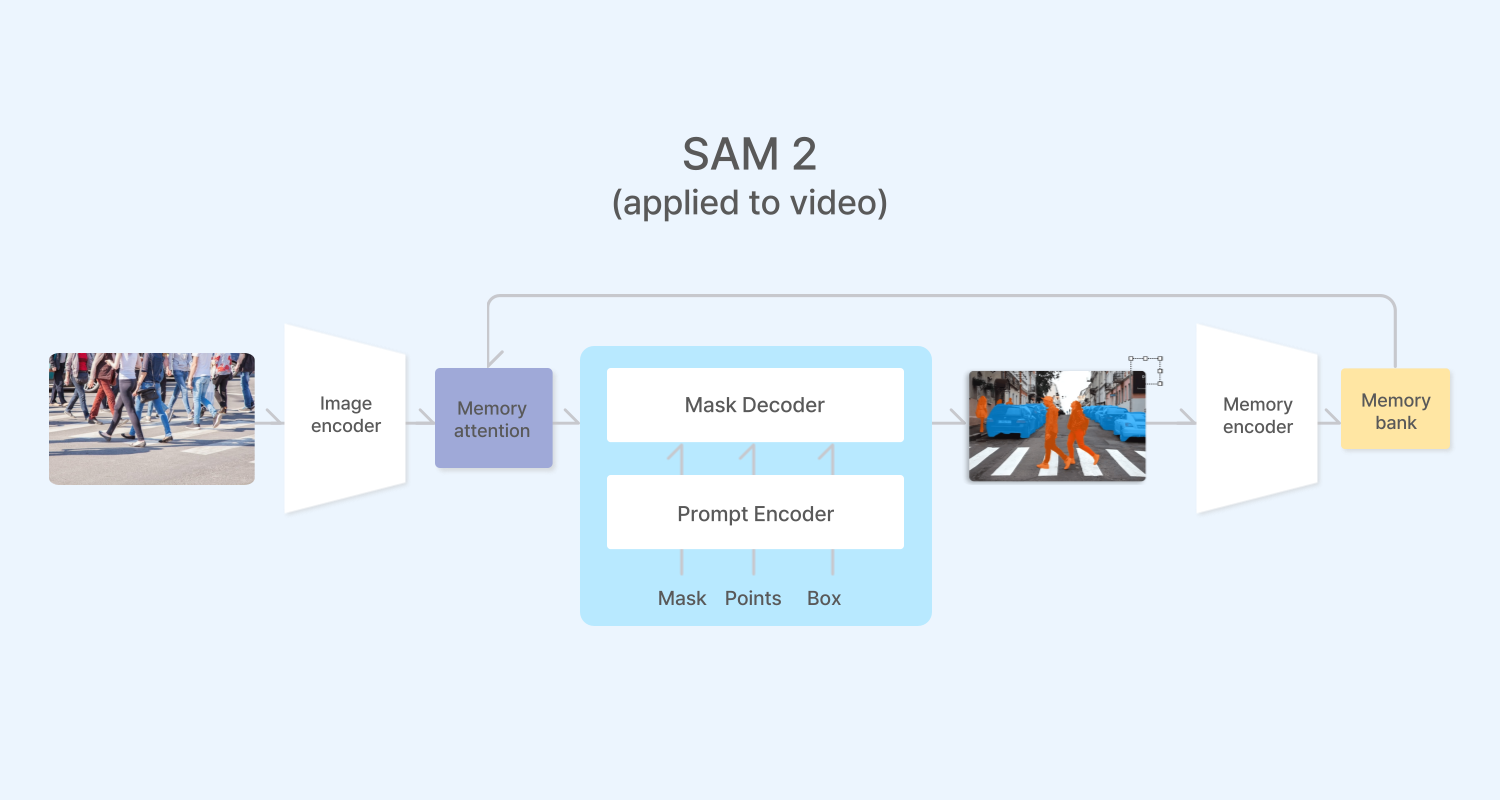

SAM 후속 모델인 SAM2를 통해 스트리밍 메모리 아키텍처를 통합하여, 긴 시퀀스에서 컨텍스트를 유지하고 비디오 프레임의 순차적 처리를 제공했어요. Meta의 SAM2는 Video Object Segmentation (VOS) 부분에서는 놀라운 성능을 보여주고 있지만, Visual Object Tracking (VOT) 시나리오에서는 가끔 오류가 일어나는 경우도 있어요.

특히, SAM2는 빠르게 움직이는 객체나 복잡한 상호 작용이 있는 시나리오 움직임을 종종 무시하고, 군중이 있는 혼잡한 장면에서 공간적 및 시간적 일관성보다 외형 유사성을 우선시하는 경향이 있어 추적 오류가 발생되는 경우에요.

이러한 한계를 해결하기 위해, 모 연구실에서는 SAM2 모델의 예측 프로세스 모션 정보를 통합하고, 메모리 관리를 최적화하여, 시각적으로 유사한 Object를 구별하고 가려짐이 있는 경우에도 추적 정확도를 유지하는 모델의 성능을 향상시킬 수 있었어요.

|

복잡하고 빠른 객체를 실시간 추적하는

|

| SAMURAI 모델 데모영상

SAMURAI Model 이란?

정식 명칭은 SAM-based Unified and Robust zero-shot visual tracker with motion-Aware Instance-level memory. Meta의 SAM2 모델을 기반으로 한 객체 추적 모델이에요. SAMURAI는 제로샷 추적을 위해 설계되었으며, LaSOT, GOT-10k 등의 여러 벤치마크에서 최고 성능 달성할 수 있는데요. 입력된 이미지에서 객체를 더욱 정밀하게 세분화할 수 있어, 인물이 많거나 빠른 복잡한 동적 장면을 이해하고 분석하는 데 특화되어 있어요.🙌

SAM2 성능을 보안한 SAMURAI 모델 설계

앞서, SAM2는 Visual Object Tracking(VOT)와 Vidieo Object Segmentation(VOS)에서 강력한 성능을 보였지만, 잘못되거나 신뢰도 낮은 Object를 실수로 인코딩한다면 긴 시퀀스의 VOT에서 상당한 오차 전파를 초래할 수 있다는 리스크가 있었어요.

워싱턴 대학교에서는 위의 한계 리스크를 해결하기 위해 칼만 필터(KF) 기반의 모션 모델링과, affinity score와 motion score를 결합한 하이브리드 스코어링 시스템을 기반으로 향상된 메모리 선택을 진행했어요. 이는 복잡한 동영상에서 object를 정확하게 추적하는 모델의 능력을 강화하도록 설계되었답니다! 여기에 SAMURAI 모델 역시, SAM 모델과 같이 파인튜닝이나 추가 학습이 필요하지 않으며, 기존 SAM2 모델에 직접 통합할 수 있어요.

🟦 모션 모델링 통합

모션 모델링에 선형 칼만 필터를 사용한 모션 모델링을 통합함으로써, Visual Object Tracking(VOT)와 Multiple Object Tracking(MOT)에 대한 모호성을 해결하고, Bounding Box 위치 및 차원 예측을 향상시켰어요.

🟦효과적인 메모리 장치 선택

SAMURAI 모델에서는 모션을 고려한 효과적인 memory bank를 구성하기 위해 mask affinity score, object score, motion score의 세 가지 score에 따라 이전 timestep에서 프레임을 선택하는 선택적 접근 방식을 사용했어요.

따라서, 제안된 모션 모델링 및 메모리 선택 모듈은 재학습 없이도 COT를 크게 향상시킬 수 있으며 기존 파이프라인에 어떠한 계산 오버헤드도 추가하지 않아요. 또 모델에 구애받지 않으며 SAM2를 넘어 다른 프레임워크에도 잠재적 적용이 가능하죠.

SAM2와 비교한 SAMURAI 성능

SAMURAI 모델은 SAM2 모델과 비교하여, 실제 환경에서 복잡하고 역동적인 시각적 객체 추적 문제를 해결하는 데 중요한 역할을 할 수 있어요. 특정 객체를 타겟으로 움직임을 정확하게 추적하기 때문에 가림, 군중, 빠른 움직임 등의 재난구조, 스포츠 분석 등의 영역에서 응용될 수 있어요.

🟦모션 인식 메모리 선택

SAMURAI는 객체의 움직임을 예측하고, 이를 바탕으로 메모리 선택을 개선하여 정확한 마스크 예측을 수행해요. 이로 인해 가림과 변경이 빈번하게 발생하는 상황에서도 효과적으로 추적할 수 있게끔 메모리 선택 메커니즘을 구현했어요.

🟦움직임 기반 점수 도입

SAMURAI는 NVIDIA RTX 4090 GPU에서 일관된 성능을 유지하며, 실시간으로 비디오 프레임을 처리할 수 있는 능력을 갖추고 있어요.

🟦견고한 성능과 일반화 능력

SAMURAI에서 새롭게 제안된 모듈은 SAM2의 모든 변형에서 일관된 성능 개선을 가져왔으며, 다양한 벤치마크 데이터 셋에서 기존의 추적 방법들에 비해 성공률과 정밀도에서 유의미한 개선이 이루어졌어요. 예를 들어, LaSOT 데이터 셋에서 7.1%의 AUC 향상과 GOT-10k에서 3.5%의 AO 향상을 기록했어요.

SAMURAI의 등장으로 객체 추적 기술은 한 단계 더 진화한 것을 알아볼 수 있었는데요. 단순 흥미와 재미를 위한 가상 현실 속 상호작용 개선부터 스마트 감시 시스템까지 SAMURAI를 도입하여, 실생활의 효율성과 안정성을 높여볼 수 있어요. 또한, 씨이랩에서 제공하는 다양한 솔루션과 결합할 시, 그 응용 범위가 더욱 넓어지는데요!

AI 영상분석 전문 기업 씨이랩의 빠르고 정확한 객체인식-추적을 통해 새로운 비즈니스를 확장해 보세요!

'AI 정보' 카테고리의 다른 글

| AI 시대 새로운 과제, '에너지 효율' 씨이랩 Ecosystem 솔루션으로 해결 (0) | 2024.08.04 |

|---|---|

| 마케팅 도서 추천: 당신의 마케팅 지식을 한 단계 업그레이드할 책 5권 📚 (2) | 2024.03.26 |

| 2030 재테크 유튜버 추천 5💸 (2) | 2024.03.22 |

| 2024년 벚꽃 개화시기🌸 전국 벚꽃 축제 총정리 (0) | 2024.03.12 |

| 구글 제미나이 이미지 생성 기능 중단, 몇 주 내 재개 (0) | 2024.02.28 |