인공지능이 하는 그럴듯한

거짓말 ‘AI 할루시네이션’

지난 시간 LLM과 LLMOps를 이야기하며, 거대 언어 모델이 개인 일상과 기업에 미치는 영향이 커지고 있음을 짐작할 수 있었어요. 하지만 이러한 생성형 AI에도 큰 골칫거리가 있는데요. 바로 ‘할루시네이션(Hallucination)’으로 불리는 AI 환각 현상입니다.

할루시네이션은 맥락과 관계없거나 사실과 무관한 정보를 마치 정답인 것처럼 이야기하면서 정보 획득에 혼란을 불러오는 것인데요.

🤖 우리가 ChatGPT를 활용하면서, 다양한 질문과 명령을 내리다 보면, 논지에 벗어난 답변이나 잘못된 답변을 가져오는 경우처럼 ‘허위’정보를 ‘사실’인 척 위장한답니다.💦 특히 의료·법률·금융·경제 분야 등 중요한 의사 결정에 활용되어 부적절한 결정을 내릴 경우, 경제적 손실과 법적 문제까지 이어지는 등 어마어마한 리스크가 기다리고 있는데요.

이렇게 최근 AI의 최대 난제라고 불리며 많은 기업들에게 곤란함을 주는 할루시네이션, 해결 방법은 있을까요? 할루시네이션의 원인과 대응 방안 등을 알아볼게요!

🤖 AI 환각, 할루시네이션(Hallucination)의 정의

AI 업계에서의 할루시네이션은 환각 또는 망상 등으로 불리며, AI가 생성한 정보에 허위 또는 날조된 정보가 포함되는 현상을 말해요. 실제 사실과 AI를 거친 정보가 다른 내재성 환각과 실제로 존재하지 않는 사실을 창작해서 제공하는 외재적 환각으로 나뉩니다.

ChatGPT에 질문했을 때 역사적 사실을 왜곡하거나, 이미지 생성 시 현실 법칙에 위배된 이미지 등을 제공하는 게 바로 할루시네이션 현상인데요! 예를 들어, 지난해 2월 마이크로소프트가 빙 AI를 공개할 당시, 빙 AI에게 의류기업(Gap)의 수익 보고서를 분석하라고 요청했어요. 📖

🗨️빙 AI는 갭의 영업이익률이 5.9%라고 답했는데, 실제 이익률은 4.6%였으며, 보고서에는 5.9라는 해당 수치는 없었답니다.😢 이런 AI 환각 현상은 자연어 처리 분야에서 주로 나타나고 있어요.

✅ 할루시네이션(Hallucination), 왜 나타날까?

AI 할루시네이션이 NLP에서 발생되는 주된 이유는 학습 데이터의 문제 덕분인데요. 수집한 데이터 자체가 잘못된 사실을 다루고 있거나, 데이터를 혼합하는 과정에서 문제가 생겨요. 대다수 생성형 AI는 사전에 훈련된 데이터를 바탕으로 응답하지만, 통계적으로 불완전한 모델이 생성되면서 할루시네이션이 나타날 수 있어요.

2020년에 혐오 발언으로 논란이 있었던 이루다 챗봇이 커뮤니티 내 차별, 비하 발언 등을 학습해 그대로 노출되었던 것처럼, 잘못된 데이터 인풋을 통해 잘못된 아웃풋이 나오기도 해요.

이처럼, AI 언어 모델은 워낙 방대한 데이터를 한 번에 학습하기 때문에 과정에 오류가 생기거나 계산과 통계를 활용해 효율적인 정보처리를 하려 하는데요. 확률상 가장 높은 답변을 내놓기 전에 진위는 확인할 수는 없어, 이것이 생성형 AI의 한계로 꼽히기도 해요.😢

또한, 할루시네이션은 자연어 처리를 넘어 거의 모든 AI 분야에서 발생하고 있어요. 사람이나 물체를 감지하는 AI가 전혀 다른 객체로 인식하거나, 사물을 사람으로 인식하는 것은 단순 오류이지만, 실제 할루시네이션이 개입하게 되면, 없는 객체를 인식하거나 피사체를 전혀 다른 물체로 판단해 오작동을 일으킬 수 있어요!🚨

현재 많은 생성형 AI에서도 원근법을 무시하거나, 인체 비례가 맞지 않는 등의 환각 영상이 제작되기도 해요.

✅ 할루시네이션 예방 방법/해결 방법

🔷고품질 학습 데이터 제공: 다양한 학습 데이터를 사용하여 AI 모델이 여러 가지 상황과 시나리오에 노출되도록 하여 모델이 부정확하거나 오해 소지가 있는 결과를 생성하는 것을 방지할 수 있어요.

🔷자연어처리기술 기반 문맥 개선: 명명엔티티 인식 혹은 감정 분석과 같은 자연어 처리 기술을 사용하여 모델 효율성을 향상시킬 수 있어요. 질문의 맥락을 분석하고 사용자 이력이나 선호도에 따라 추가 정보를 제공하여 맥락을 이해시킬 수 있는데요.

추가 정보 학습은 할루시네이션에 대한 위험을 최소화하면서 모델이 보다 정확하고 적절한 응답을 생성하는 데 도움을 줄 수 있습니다!😊

🔷RLHF을 통한 보상 모델 개발: 전문가 등의 사람의 도움을 받아 인간의 선호도와 피드백을 기반으로 보상 모델을 개발할 수 있습니다. 피드백을 통해 모델 동작의 정확도를 개선할 수 있으며, 이 과정에서는 모델이 질문에 확실하게 대답할 수 없다고 말하는 방법을 배우는 것도 포함됩니다.

AI 할루시네이션 방지를 위한

고품질 데이터 학습 astrago

AI 환각, 할루시네이션으로 알아본 정보와 같이 AI 서비스에는 대량의 데이터 처리가 필요해요. 이때 많은 AI 기업은 데이터를 학습시키는 데 오류가 생기지 않도록 모델을 개발하는 등 많은 노력을 기울이고 있답니다.

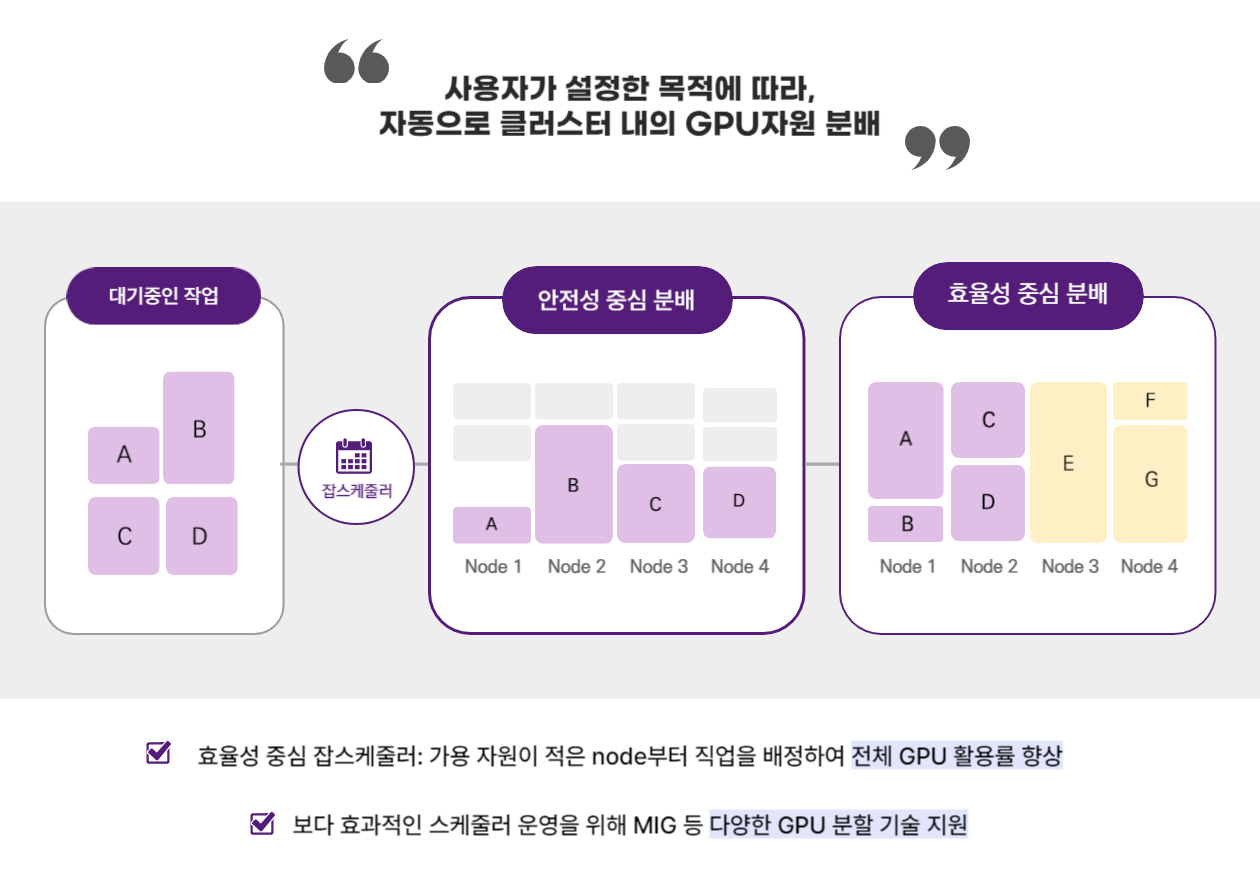

기업에서는 대용량 데이터를 효율적으로 다루기 위한 방법 중 하나로 GPU 분할 기술을 이용하고 있어요. Multi Instance GPU의 약자인 MIG는 단일 GPU를 여러 개의 논리적 GPU로 분할하여 여러 작업에 할당하는 기술이에요. 씨이랩의 astrago 솔루션에서도 MIG 기반 GPU 분할과 효율 중심 스케줄러로 효과적인 분배가 가능하답니다.

astrago는 고가&고성능의 GPU을 다수의 팀에서 효율적으로 나눠쓸 수 있도록 MIG(Multi Instance GPU) 방식을 지원하고 있어, GPU 1개를 최대 7개의 가상 GPU로 생성하게 해요.

해당 기능을 사용하면 기업의 AI 모델의 개발과 배포 속도를 향상시킬 수 있어, AI 추론 작업에 유리한데요. 최대 7명의 개발자가 전용 GPU와 같은 기능에 동시 액세스할 수 있으므로 최적의 정확성과 성능을 위한 효율적 모델 튜닝이 가능합니다!😎

|

"오늘은 AI 할루시네이션, 환각 현상을 알아보며 데이터 수집 및 학습 데이터의 중요성에 대해서 느낄 수 있었던 시간인데요.

별도의 환경 구축 없이도 다양한 딥러닝 프레임워크와 WebIDE 이용이 가능하고, 학습 검증 모니터링을 할 수 있어 AI 인프라 관리 효율을 향상시킬 수 있는 astrago! astrago를 통해 고품질 고효율 데이터를 관리해 보시는 건 어떨까요?" |

'AstraGo' 카테고리의 다른 글

| LLM 한계를 보완할 수 있는 AI 검색증강생성 RAG 기술 (3) | 2024.07.05 |

|---|---|

| 우리의 생활로 들어오는 똑똑한 범용인공지능 AGI 개념과 사례 (0) | 2024.07.05 |

| 기업에서 LLM을 효과적으로 관리하는 LLMOps 프로세스 (3) | 2024.07.01 |

| AI 학습에 적합한 합성곱신경망 CNN과 순환신경망 RNN의 차이 (1) | 2024.07.01 |

| AI·딥러닝 개발자라면 필수! 병렬처리 컴퓨팅 플랫폼 'CUDA' (3) | 2024.07.01 |